伦敦当地时间10月18日18:00(北京时间19日01:00),AlphaGo再次登上世界顶级科学杂志——《自然》。

一年多前,AlphaGo便是2016年1月28日当期的封面文章,Deepmind公司发表重磅论文,介绍了这个击败欧洲围棋冠军樊麾的人工智能程序。

今年5月,以3:0的比分赢下中国棋手柯洁后,AlphaGo宣布退役,但DeepMind公司并没有停下研究的脚步。伦敦当地时间10月18日,DeepMind团队公布了最强版AlphaGo ,代号AlphaGo Zero。它的独门秘籍,是“自学成才”。而且,是从一张白纸开始,零基础学习,在短短3天内,成为顶级高手。

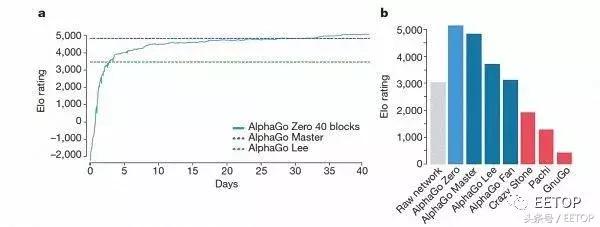

团队称,AlphaGo Zero的水平已经超过之前所有版本的AlphaGo。在对阵曾赢下韩国棋手李世石那版AlphaGo时,AlphaGo Zero取得了100:0的压倒性战绩。DeepMind团队将关于AlphaGo Zero的相关研究以论文的形式,刊发在了10月18日的《自然》杂志上。

“AlphaGo在两年内达到的成绩令人震惊。现在,AlphaGo Zero是我们最强版本,它提升了很多。Zero提高了计算效率,并且没有使用到任何人类围棋数据,”AlphaGo之父、DeepMind联合创始人兼CEO 戴密斯·哈萨比斯(Demis Hassabis)说,“最终,我们想要利用它的算法突破,去帮助解决各种紧迫的现实世界问题,如蛋白质折叠或设计新材料。如果我们通过AlphaGo,可以在这些问题上取得进展,那么它就有潜力推动人们理解生命,并以积极的方式影响我们的生活。”

不再受人类知识限制,只用4个TPU

AlphaGo此前的版本,结合了数百万人类围棋专家的棋谱,以及强化学习的监督学习进行了自我训练。

在战胜人类围棋职业高手之前,它经过了好几个月的训练,依靠的是多台机器和48个TPU(谷歌专为加速深层神经网络运算能力而研发的芯片)。

AlphaGo Zero的能力则在这个基础上有了质的提升。最大的区别是,它不再需要人类数据。也就是说,它一开始就没有接触过人类棋谱。研发团队只是让它自由随意地在棋盘上下棋,然后进行自我博弈。值得一提的是,AlphaGo Zero还非常“低碳”,只用到了一台机器和4个TPU,极大地节省了资源。

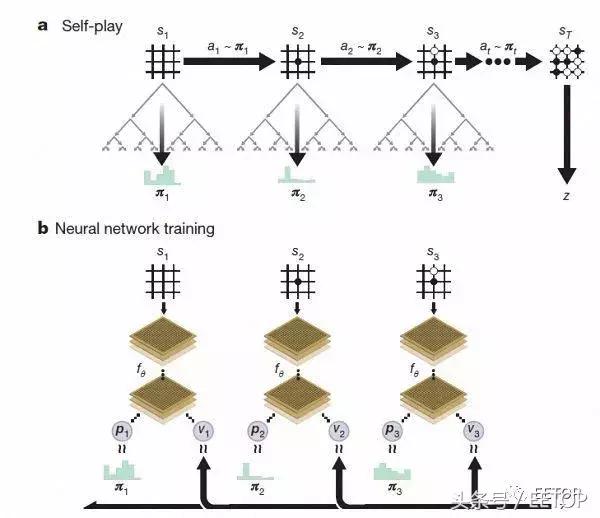

AlphaGo Zero强化学习下的自我对弈

经过几天的训练,AlphaGo Zero完成了近5百万盘的自我博弈后,已经可以超越人类,并击败了此前所有版本的AlphaGo。DeepMind团队在官方博客上称,Zero用更新后的神经网络和搜索算法重组,随着训练地加深,系统的表现一点一点地在进步。自我博弈的成绩也越来越好,同时,神经网络也变得更准确。

AlphaGo Zero习得知识的过程

“这些技术细节强于此前版本的原因是,我们不再受到人类知识的限制,它可以向围棋领域里最高的选手——AlphaGo自身学习。” AlphaGo团队负责人大卫·席尔瓦(Dave Sliver)说。

据大卫·席尔瓦介绍,AlphaGo Zero使用新的强化学习方法,让自己变成了老师。系统一开始甚至并不知道什么是围棋,只是从单一神经网络开始,通过神经网络强大的搜索算法,进行了自我对弈。

随着自我博弈的增加,神经网络逐渐调整,提升预测下一步的能力,最终赢得比赛。更为厉害的是,随着训练的深入,DeepMind团队发现,AlphaGo Zero还独立发现了游戏规则,并走出了新策略,为围棋这项古老游戏带来了新的见解。

自学3天,就打败了旧版AlphaGo

除了上述的区别之外,AlphaGo Zero还在3个方面与此前版本有明显差别。

AlphaGo-Zero的训练时间轴

首先,AlphaGo Zero仅用棋盘上的黑白子作为输入,而前代则包括了小部分人工设计的特征输入。

其次,AlphaGo Zero仅用了单一的神经网络。在此前的版本中,AlphaGo用到了“策略网络”来选择下一步棋的走法,以及使用“价值网络”来预测每一步棋后的赢家。而在新的版本中,这两个神经网络合二为一,从而让它能得到更高效的训练和评估。

第三,AlphaGo Zero并不使用快速、随机的走子方法。在此前的版本中,AlphaGo用的是快速走子方法,来预测哪个玩家会从当前的局面中赢得比赛。相反,新版本依靠地是其高质量的神经网络来评估下棋的局势。

AlphaGo几个版本的排名情况

据哈萨比斯和席尔瓦介绍,以上这些不同帮助新版AlphaGo在系统上有了提升,而算法的改变让系统变得更强更有效。

经过短短3天的自我训练,AlphaGo Zero就强势打败了此前战胜李世石的旧版AlphaGo,战绩是100:0的。经过40天的自我训练,AlphaGo Zero又打败了AlphaGo Master版本。“Master”曾击败过世界顶尖的围棋选手,甚至包括世界排名第一的柯洁。

对于希望利用人工智能推动人类社会进步为使命的DeepMind来说,围棋并不是AlphaGo的终极奥义,他们的目标始终是要利用AlphaGo打造通用的、探索宇宙的终极工具。AlphaGo Zero的提升,让DeepMind看到了利用人工智能技术改变人类命运的突破。他们目前正积极与英国医疗机构和电力能源部门合作,提高看病效率和能源效率。

以下转载一篇关于论文深度解读,部分内容会与前面部分有重复

论文深度解读

作者: 开明 Nature上海办公室

人工智能棋手 AlphaGo先后战胜了两位顶尖围棋高手李世乭和柯洁。在这场猛烈风暴席卷了世界后,AlphaGo宣布不再和人下棋。但它的创造者并没有因此停下脚步,AlphaGo还在成长,今天Deepmind又在《自然》期刊上发表了关于 AlphaGo的新论文。

Deepmind于2016年1月28日在Nature杂志上发表第一篇关于AlphaGo的论文,并登

这篇论文中的 AlphaGo是全新的,它不是战胜柯洁的那个最强的 Master,但却是孪生兄弟。它的名字叫AlphaGo Zero。和以前的 AlphaGo相比,它:

• 从零开始学习,不需要任何人类的经验

• 使用更少的算力得到了更好的结果

• 发现了新的围棋定式

• 将策略网络和值网络合并

• 使用了深度残差网络

白板理论(Tabula rasa)

AlphaGo Zero最大的突破是实现了白板理论。白板理论是哲学上的一个著名观点,认为婴儿生下来是白板一块,通过不断训练、成长获得知识和智力。

作为 AI 领域的先驱,图灵使用了这个想法。在提出了著名的“图灵测试”的论文中,他从婴儿是一块白板出发,认为只要能用机器制造一个类似小孩的 AI,然后加以训练,就能得到一个近似成人智力,甚至超越人类智力的AI。

现代科学了解到的事实并不是这样,婴儿生下来就有先天的一些能力,他们偏爱高热量的食物,饿了就会哭闹希望得到注意。这是生物体在亿万年的演化中学来的。

监督学习 Vs 无监督学习

计算机则完全不同,它没有亿万年的演化,因此也没有这些先天的知识,是真正的“白板一块”。监督学习(Supervised Learning)和无监督学习(Unsupervised Learning)是镜子的两面,两者都想解决同一个问题——如何让机器从零开始获得智能?

监督学习认为人要把自己的经验教给机器。拿分辨猫猫和狗狗的AI来说,你需要准备几千张照片,然后手把手教机器——哪张照片是猫,哪张照片是狗。机器会从中学习到分辨猫狗的细节,从毛发到眼睛到耳朵,然后举一反三得去判断一张它从没见过的照片是猫猫还是狗狗。

而无监督学习认为机器要去自己摸索,自己发现规律。人的经验或许能帮助机器掌握智能,但或许人的经验是有缺陷的,不如让机器自己发现新的,更好的规律。人的经验就放一边吧。

从无知到无敌

就像这篇新论文中讲述的那样。AlphaGo Zero是无监督学习的产物,而它的双胞胎兄弟Master则用了监督学习的方法。在训练了72小时后AlphaGo Zero就能打败战胜李世乭的 AlphaGo Lee,相比较AlphaGo Lee训练了几个月。而40天后,它能以89:11的成绩,将战胜了所有人类高手的Master甩在后面。

AlphaGo Zero从0开始的学习曲线,这个版本的神经网络由40个模块组成。

图灵的白板假设虽然无法用在人身上,但是AlphaGo Zero证明了,一个白板AI能够被训练成超越人类的围棋高手。

强化学习

强化学习(Reinforcement Learning)是一种模仿人类学习方式的模型,它的基本方法是:要是机器得到了好的结果就能得到奖励,要是得到差的结果就得到惩罚。AlphaGo Zero并没有像之前的兄弟姐妹一样被教育了人类的围棋知识。它只是和不同版本的自己下棋,然后用胜者的思路来训练新的版本,如此不断重复。

AlphaGo Zero就像人类初学者,需要经历一定时间摸索。不同训练阶段进行的三场自我对弈游戏中的

通过这一方法,AlphaGo Zero完全自己摸索出了开局、收官、定式等以前人类已知的围棋知识,也摸索出了新的定势。

算法和性能

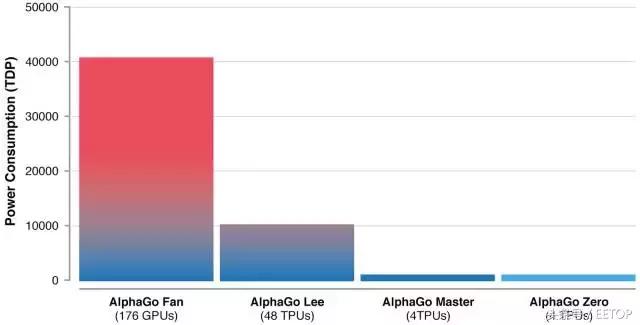

如何高效合理得利用计算资源?这是算法要解决的一个重要问题。AlphaGo Lee使用了48个TPU,更早版本的 AlphaGo Fan(打败了樊麾的版本)使用了176个GPU,而Master和AlphaGo Zero仅仅用了4个TPU,也就是说一台电脑足够!

由于在硬件和算法上的进步,AlphaGo变得越来越有效率。

AlphaGo Zero在72小时内就能超越AlphaGo Lee也表明,优秀的算法不仅仅能降低能耗,也能极大提高效率。另外这也说明,围棋问题的复杂度并不需要动用大规模的计算能力,那是只浪费。

AlphaGo Zero的算法有两处核心优化:将策略网络(计算下子的概率)和值网络(计算胜率)这两个神经网络结合,其实在第一篇 AlphaGo的论文中,这两种网络已经使用了类似的架构。另外,引入了深度残差网络(Deep Residual Network),比起之前的多层神经网络效果更好。

Deepmind 的历程

这不是 Deepmind第一次在《自然》上发论文,他们还在Nature上发表过《利用深度神经网络和搜索树成为围棋大师》和《使用深度强化学习达到人类游戏玩家水平》(论文链接://rdcu.be/wRDs)以及《使用神经网络和动态外存的混合计算模型》三篇论文,Deepmind在Nature Neuroscience上也发过多篇论文。

我们可以从中一窥 Deepmind的思路,他们寻找人类还没有理解原理的游戏,游戏比起现实世界的问题要简单很多。然后他们选择了两条路,一条道路是优化算法,另外一条道路是让机器不受人类先入为主经验的影响。

这两条路交汇的终点,是那个真正能够超越人的AI。

结语

这是AlphaGo 的终曲,也是一个全新的开始,相关技术将被用于造福人类,帮助科学家认识蛋白质折叠,制造出治疗疑难杂症的药物,开发新材料,以制造以出更好的产品。

本文来源:【EETOP】版权归原作者所有

责任编辑:金林舒

- 阿尔法狗再进化:自学3天打败旧版AlphaGo 最强阿尔法狗诞生有什么意义2017-10-19

- 最强阿尔法狗诞生:AlphaGo Zero横空出世,阿尔法狗退役2017-10-19

- 经阿法狗洗礼升级为“半人半狗”?柯洁:我的漏洞他们没抓住2017-07-09

- 高考最新报道 机器人参加高考:断网答题10分钟得100分 机器人是AlphaGo吗?2017-06-08

- 柯洁对战阿尔法狗败后 柯洁大胜韩国棋手:和人类下棋这么轻松快乐2017-05-31

- “狗咬狗”会发生什么?首先他毁了人类“三观”2017-05-30

- 柯洁三战AlphaGo皆败 李世石:他应得到掌声2017-05-28

- 柯洁0比3负于AlphaGo 人机大战柯洁连输三局完败2017-05-27

- 柯洁投子认输 人机大战AlphaGo3:0大胜柯洁 柯洁和李世石谁厉害?2017-05-27

- 人机大战最后一役 AlphaGo控场稳定柯洁全力一拼虽败犹荣2017-05-27

- 最新科技前沿 频道推荐

-

夏普收编康达智 发力相机模组意在苹果2017-11-12

- 进入图片频道最新图文

- 进入视频频道最新视频

- 一周热点新闻

已有0人发表了评论